هوش مصنوعی، بهویژه هوش مصنوعی مولد (Generative AI)، بهسرعت در حال پیشرفت است و دسترسی به آن برای کاربران عادی روزبهروز آسانتر میشود. با ظهور مدلهای زبانی بزرگ (LLM) مانند GPT و LLaMA، تمایل به اجرای این مدلها بهصورت محلی روی سختافزار شخصی افزایش یافته است. این مقاله راهنمای سادهای برای راهاندازی Ollama (ابزاری برای اجرای LLMها بهصورت محلی) بر روی ماشینهایی با و بدون GPU ارائه میدهد. همچنین، نحوه راه اندازی OpenWebUI با استفاده از Podman یا Docker برای فراهمکردن یک رابط گرافیکی محلی جهت تعامل با هوش مصنوعی مولد را پوشش میدهد.

Ollama چیست؟

Ollama پلتفرمی است که به کاربران امکان میدهد مدلهای زبانی بزرگ را بهصورت محلی و بدون نیاز به سرویسهای ابری اجرا کنند. این پلتفرم بهگونهای طراحی شده است که کاربر پسند بوده و از مدلهای متنوعی پشتیبانی میکند. با اجرای مدلها بهصورت محلی، کاربران میتوانند حریم خصوصی بیشتری را تضمین کرده، تأخیر را کاهش داده و کنترل بیشتری بر دادههای خود داشته باشند.

راهاندازی Ollama روی ماشین

Ollama را میتوان روی ماشینهایی با یا بدون GPU اختصاصی اجرا کرد. در ادامه، مراحل کلی برای هر دو پیکربندی توضیح داده شده است.

۱. پیشنیازها

قبل از ادامه، اطمینان حاصل کنید که موارد زیر را دارید:

- سیستمی با Fedora یا توزیع لینوکس

- نصب Podman یا Docker (برای راه اندازی OpenWebUI)

- فضای دیسک کافی برای ذخیره مدلها

برای ماشینهای دارای GPU، همچنین به موارد زیر نیاز دارید:

۲. نصب Ollama

Ollama را میتوان با یک دستور نصب کرد:

# curl -fsSL https://ollama.com/install.sh | sh

پس از نصب، با اجرای دستور زیر اطمینان حاصل کنید که Ollama بهدرستی راهاندازی شده است:

ollama --version

اجرای LLMها بهصورت محلی

پس از راهاندازی Ollama، میتوانید مدل مورد نظر خود را دانلود کرده و بهصورت محلی اجرا کنید. مدلها اندازههای متفاوتی دارند، بنابراین مدلی را انتخاب کنید که با قابلیتهای سختافزاری شما سازگار باشد. برای دیدن مدل ها می توانید به لینک زیر مراجعه کنید:

https://ollama.com/search

برای مثال، مدل llama3.3 70B حدود ۴۲ گیگابایت حجم دارد و ممکن است برای همه مناسب نباشد. مدلهای متنوعی برای نیازهای مختلف وجود دارد؛ حتی برای raspberrypi ها. مدلی را انتخاب کنید که با سیستم شما سازگار باشد.

Ollama روی ماشینهای بدون GPU، از CPU استفاده میکند. اگرچه این روش کندتر از پردازش مبتنی بر GPU است، اما برای وظایف پایهای قابل استفاده است.

به صورت کلی برای اجرا یک مدل باید از دستور زیر استفاده کرد:

ollama run <model_name>

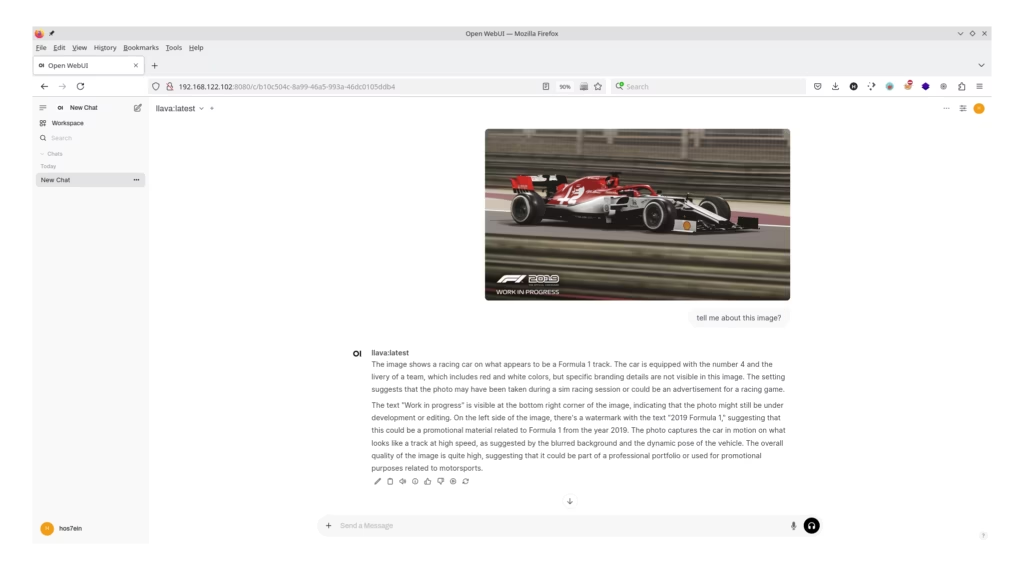

به عنوان نمونه برای اجرای مدل llava که برای پردازش تصویر کاربرد دارد می توان این دستور را اجرا کرد:

ollama run llava

اینکار باعث می شود تا مدل مورد نظر ابتدا دانلود (pull) شود و سپس اجرا شود. اکنون می توانید از طریق خط فرمان با این مدل از هوش مصنوعی تعامل داشته باشید اما در ادامه قصد داریم تا با استفاده از OpenWebUI به صورت گرافیکی و تحت وب با آن کار کنیم.

راه اندازی OpenWebUI با Podman یا Docker

برای کاربرانی که ترجیح میدهند با LLMها از طریق یک رابط کاربری گرافیکی (GUI) تعامل داشته باشند، OpenWebUI گزینهی مناسبی است. دستور زیر OpenWebUI را با استفاده از Podman یا Docker راه اندازی میکند:

podman run -d --network=host -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:main

برای اجرا با Docker کافیست در دستور بالا docker با جایگزین podman کنید. نکته اینکه اگر ollama بر روی یک ماشین دیگر اجرا شده و شما قصد دارید Open WebUI را روی یک ماشین مجزا راه اندازی کنید، در دستور بالا بجای آدرس 127.0.0.1 کافیست تا IP ماشین Ollama را وارد کنید.

اکنون جهت دسترسی به Open WebUI کافیست تا آدرس زیر را در مرورگر خود وارد کنید:

http://localhost:8080

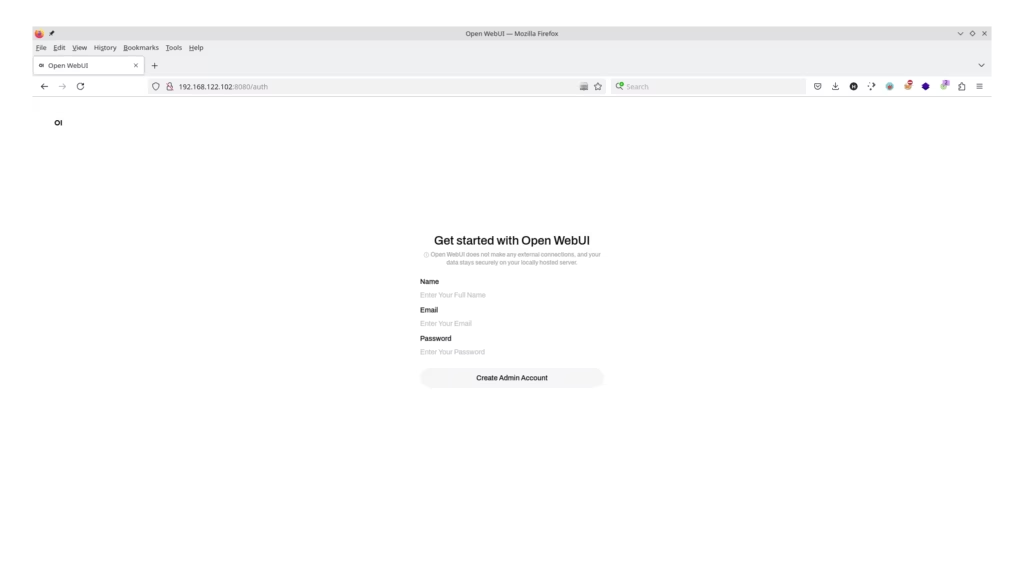

Open WebUI به شما امکان میدهد یک یا چند حساب کاربری ادمین و کاربر ایجاد کنید تا با LLMها تعامل داشته باشید. این قابلیت شبیه به کنترل دسترسی مبتنی بر نقش (RBAC) است.

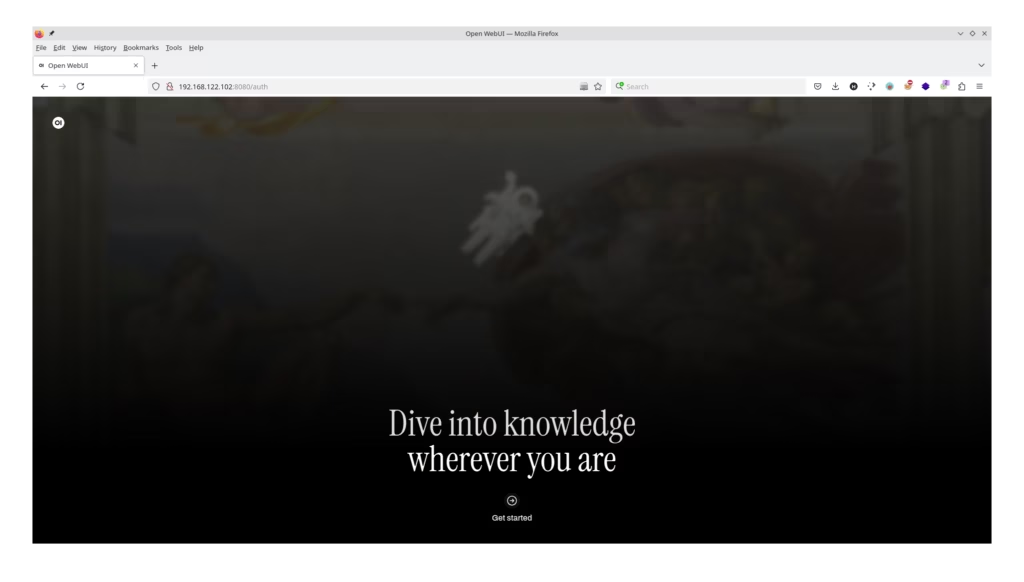

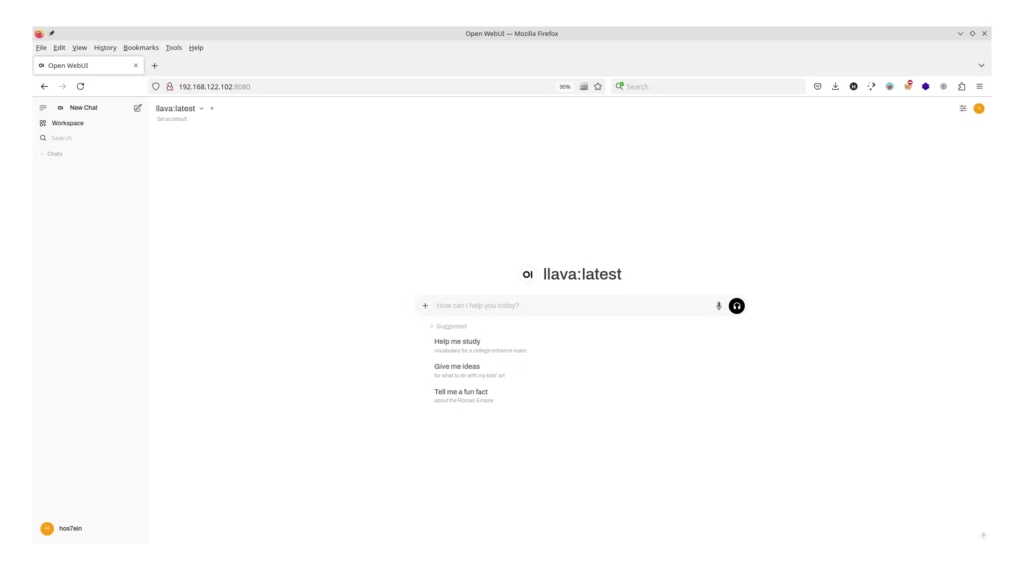

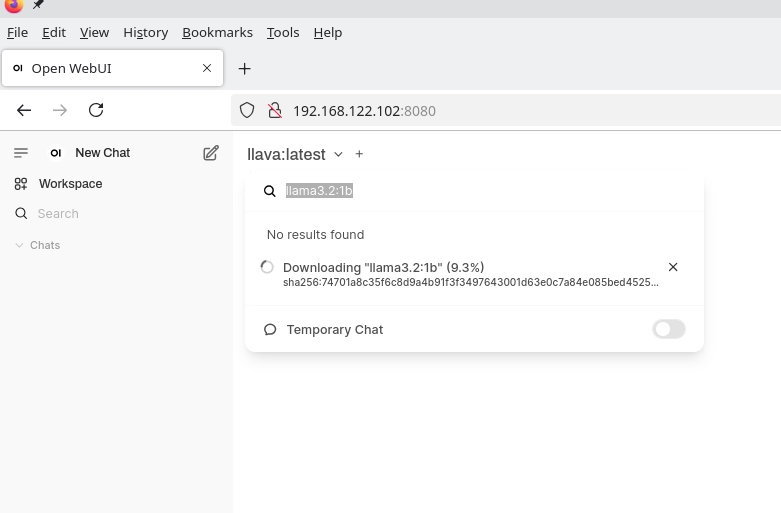

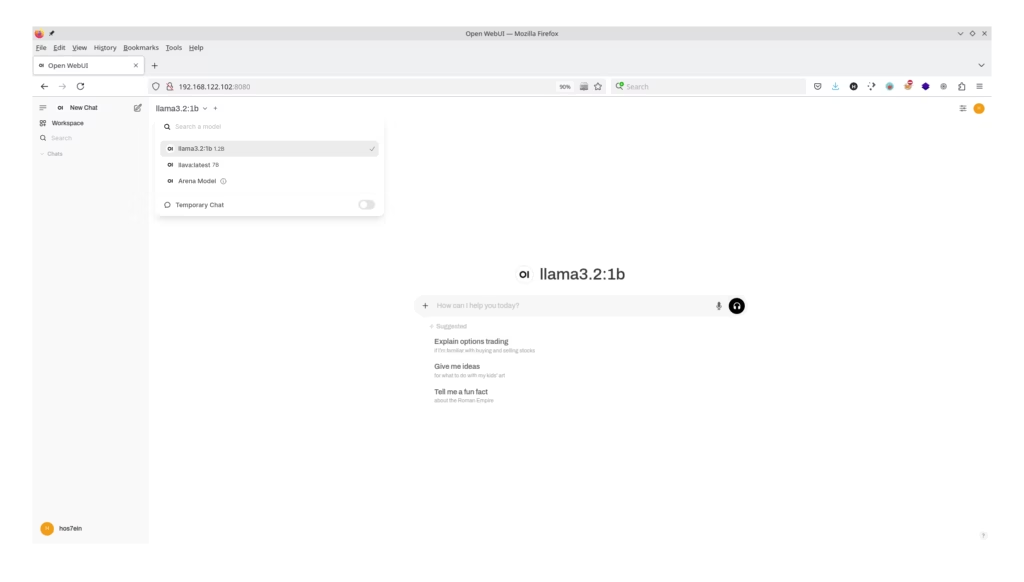

در ادامه تصاویری از Open WebUI و تعامل با Ollama را جهت پردازش تصویر با کمک مدل llava را مشاهده می کنید:

همچنین می توانید مدل های هوش مصنوعی دیگر را جستجو و استفاده کنید:

همچنین می توانید مدل های هوش مصنوعی دیگر را جستجو و استفاده کنید:

امید است تا از این مطلب استفاده لازم را برده باشید.

امید است تا از این مطلب استفاده لازم را برده باشید.